Кажется, всё сделано как надо: контент оптимизирован, техничка в порядке, статьи выходят регулярно, но сайт упорно не пробивается в топ-10. Почему так происходит? Проблема часто кроется не в базовых аспектах SEO, которые описаны в каждом руководстве, а в тонкостях, которые легко упустить из виду. Это ошибки, которые не бросаются в глаза при беглом анализе, но серьёзно влияют на ранжирование.

В этой статье мы разберём 10 неочевидных ошибок, которые могут удерживать ваш сайт за пределами топа. Каждая из них сопровождается конкретным объяснением, почему она опасна, и практическим решением. Если вы устраните эти проблемы, то значительно повысите шансы на попадание в десятку лучших результатов поиска.

1. «Нулевой клик»

Это не ошибка самого сайта, а ошибка контент-стратегии.

В чём суть: вы создаёте статью, которая идеально отвечает на запрос пользователя (например, «рост Эйфелевой башни»). А поисковая система берёт ответ прямо из вашего контента и показывает его в виде быстрого ответа или расширенного сниппета над всеми результатами.

Ошибка: пользователь получил ответ прямо в выдаче и не кликнул/не перешёл на ваш сайт (так называемый нулевой клик).

Решение: структурируйте контент так, чтобы дать прямой, краткий ответ для сниппета, но самые важные детали, кейсы или полное руководство оставались только на странице. Это заставит пользователя кликнуть для получения полной информации.

2. «Людоедство» ключевых слов (cannibalization)

Это происходит, когда вы создаёте несколько разных страниц на сайте, которые оптимизированы под один и тот же или очень похожий ключевой запрос.

В чём суть: поисковая система не может определить, какая из ваших страниц наиболее релевантна, и делит вес/ранжирование между ними. В итоге ни одна из этих страниц не может занять высокие позиции, и они «съедают» трафик друг у друга.

Пример: у вас есть статья «Как выбрать ноутбук» и другая статья «Лучшие ноутбуки 2025 года». Если обе борются за запрос «выбор ноутбука», то они каннибализируют друг друга.

Решение: объединить их в одну мощную статью или чётко разграничить их по интенту (намерению) пользователя.

3. Непонимание интента пользователя

Вы уверены, что понимаете потребности пользователя, но поисковая система видит их по-другому.

В чём суть: поисковая система ранжирует страницы не только по ключевым словам, но и по намерению (интенту), стоящему за запросом.

Пример запросов:

- «Wordpress» — интент информационный (что это такое?).

- «Wordpress скачать бесплатно» — интент транзакционный (я хочу скачать).

- «Wordpress или Tilda» — интент сравнительный.

Ошибка: создание статьи-обзора («что это») для транзакционного запроса («хочу скачать»). Поисковик видит, что пользователи, пришедшие на ваш обзор, быстро возвращаются в поиск, и понижает вашу позицию.

Решение: анализируйте топ-10 выдачи по вашему запросу. Если там 8 интернет-магазинов, значит, интент транзакционный, и ваша информационная статья там не поднимется.

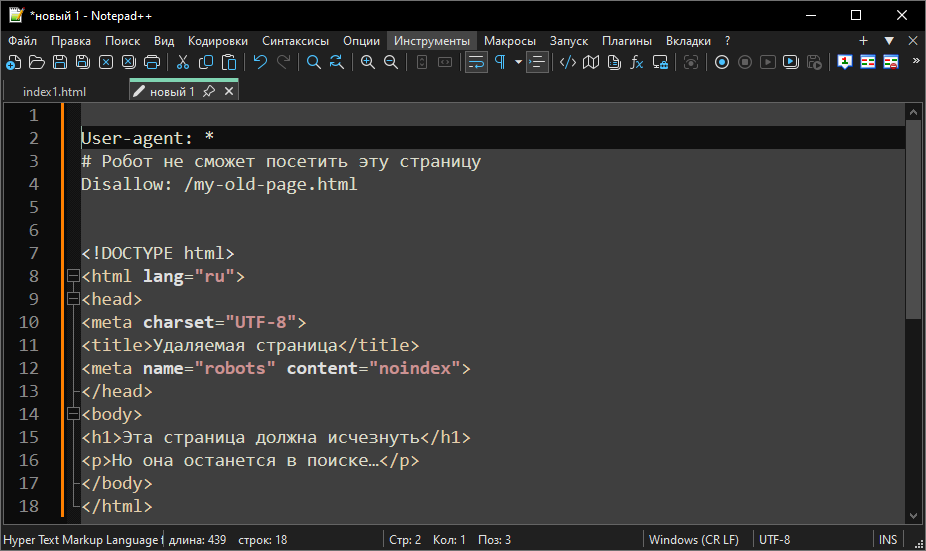

4. Одновременная блокировка команд Disallow и Noindex

Эта техническая ошибка, которая приводит к тому, что удалённые страницы навсегда остаются в поиске.

В чём суть: существуют два разных способа скрыть страницу, и их часто путают. 1) Disallow в robots.txt — это указание роботу-сканеру (краулеру) НЕ ЗАХОДИТЬ на страницу. 2) Метатег noindex — указание индексатору УДАЛИТЬ страницу из результатов поиска.

Ошибка: использование обеих команд одновременно для страницы, которую вы хотите удалить из индекса. Вы добавляете на страницу noindex, а затем закрываете её в robots.txt директивой Disallow.

Результат: вы эффективно блокируете роботу возможность прочитать команду noindex. Робот видит запрет на сканирование (Disallow) и выполняет его, но при этом он никогда не доходит до самой страницы, чтобы увидеть команду на удаление (noindex). В итоге поисковик не получает инструкций и продолжает показывать страницу в выдаче.

Решение: чтобы страница была удалена из поисковой выдачи, поисковый робот должен иметь возможность её просканировать. Используйте метатег noindex на самой странице и убедитесь, что в файле robots.txt для этого URL нет директивы Disallow. После того как робот проиндексирует страницу и обнаружит noindex, она будет исключена из индекса.

*Иногда, из соображений безопасности, допустимо временно закрыть страницу через Disallow — например, если она содержит конфиденциальные данные. Позже, когда нужно удалить её из индекса, снимите блокировку, добавьте noindex, и дождитесь, пока поисковик обновит индекс.

5. Игнорирование YMYL и E-E-A-T факторов

YMYL (Your Money or Your Life — «ваши деньги или жизнь») — это контент, который способен повлиять на финансовое состояние, здоровье, безопасность или качество жизни пользователя, и потому Google требует от таких страниц максимальной точности, экспертизы и надёжности источников.

E-E-A-T — это концепция Google, оценивающая качество контента по четырём критериям: опыт, экспертность, авторитетность и доверие к источнику.

В чём суть: поисковые системы требуют высочайшего уровня доверия к авторам и сайтам, которые дают советы по важным темам.

Ошибка: статьи на финансовую, юридическую или медицинскую тему пишутся анонимно или человеком без чётко указанной экспертизы (например, «Александров С. П.», без указания его должности/квалификации, опыта и т. д.). На сайте нет страницы «Об авторе» с его реальными достижениями или других «страниц доверия».

Решение: обязательно указывать автора статьи (с фото и именем), ссылаться на его профиль, а также ссылаться на авторитетные внешние источники (научные исследования, официальные сайты).

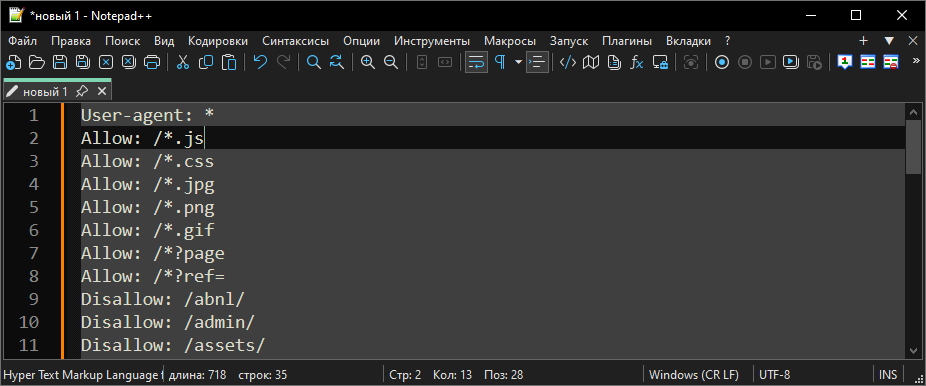

6. Ошибки в robots.txt

Это техническая ошибка, которая может привести к тому, что ваш сайт будет ранжироваться как «неполный» или «недоступный».

В чём суть: файл robots.txt даёт инструкции поисковым роботам, какие папки и файлы не нужно сканировать. Однако часто по ошибке или при установке плагинов туда попадают критически важные директивы.

Ошибка: случайная блокировка папок, содержащих CSS-файлы и JavaScript-скрипты.

Результат: поисковый робот сканирует страницу, но не может её рендерить (отобразить). Он видит только «голый» текст без дизайна, адаптивности и интерактивных элементов. Googlebot решает, что страница имеет очень низкое качество или не оптимизирована для мобильных устройств, и понижает её в выдаче.

Решение: регулярно используйте «Инструмент проверки robots.txt» в Google Search Console и «Анализ robots.txt» в Яндекс.Вебмастере, чтобы убедиться, что всё, что нужно для корректного отображения страницы, доступно для сканирования.

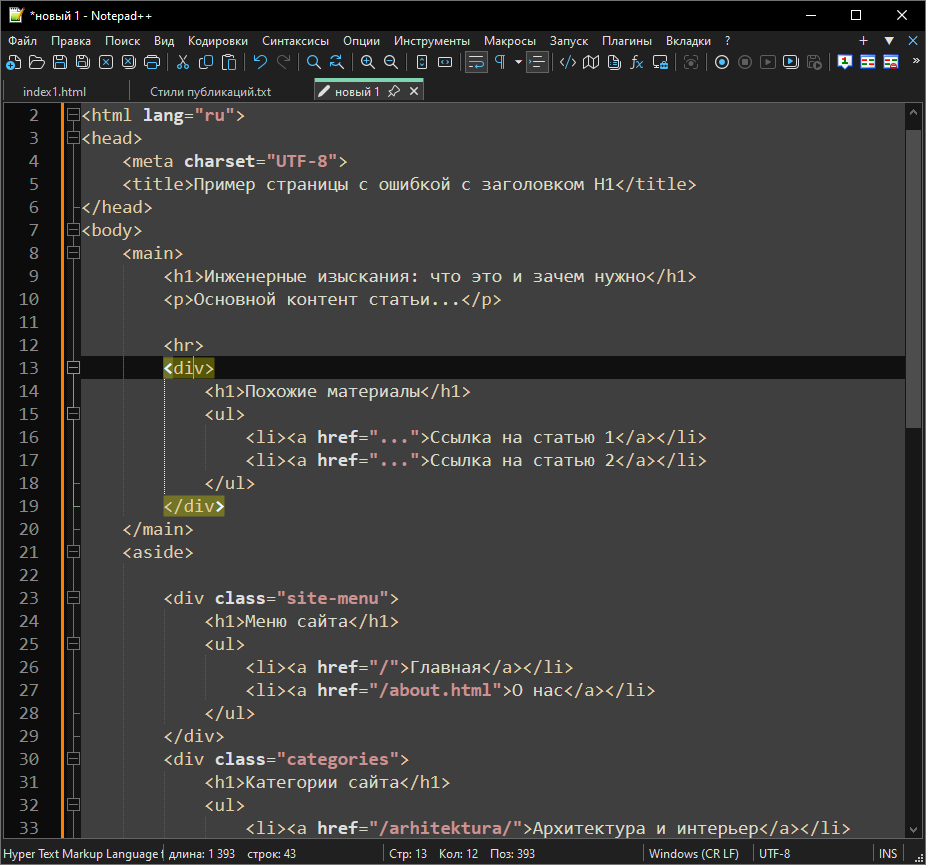

7. Нарушение «правила одного H1»

Это структурная ошибка, которая вносит путаницу в алгоритмы ранжирования.

В чём суть: заголовки H1-H6 создают логическую иерархию контента, где H1 является самым важным заголовком, описывающим главную тему страницы.

Ошибка: на одной странице используется два и более тега H1, либо H1 используется для чисто декоративных элементов (например, для слогана или названия компании).

Результат: поисковая система не может однозначно определить, какой из заголовков является главным, и под какой ключевой запрос оптимизирована страница. Это приводит к размытию релевантности страницы. Кроме того, часто нарушается логика иерархии (переход с H1 сразу на H3), что воспринимается как плохо структурированный и менее ценный контент.

Решение: проверьте все шаблоны страниц. На странице должен быть только один тег H1, который находится в самом начале основного контента и содержит главный целевой ключевой запрос.

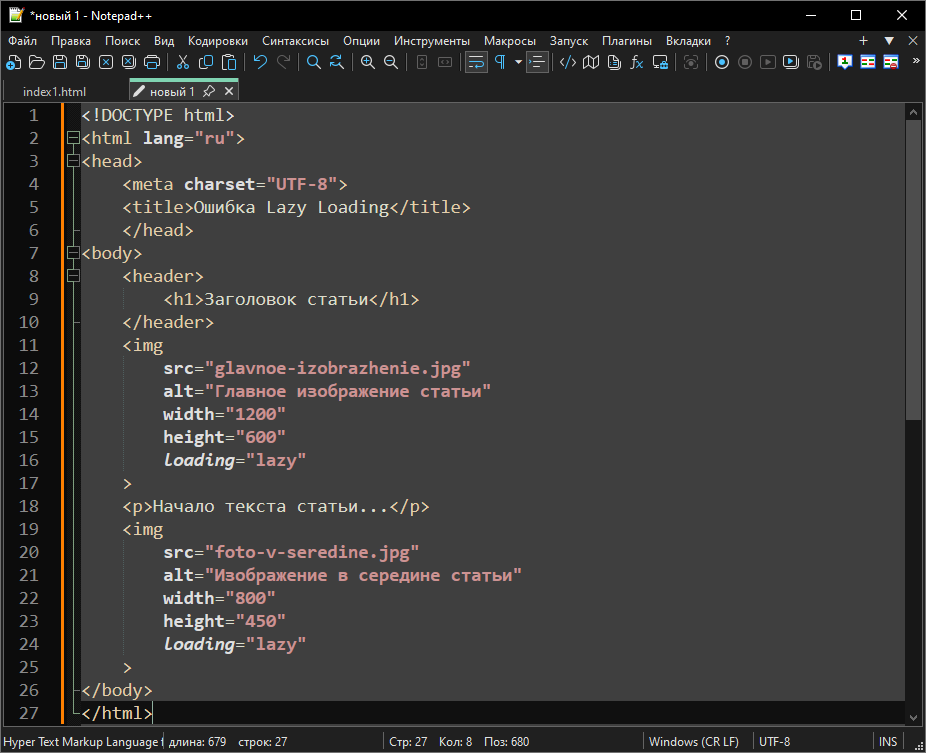

8. Отложенная загрузка важного контента (Lazy Loading) на первом экране

Функция Lazy Loading (отложенная загрузка) полезна для экономии скорости, но её использование должно быть избирательным.

В чём суть: Lazy Loading — это техника, при которой изображения или другой медиаконтент загружаются только тогда, когда пользователь до них доскроллит.

Ошибка: применение Lazy Loading к первому экрану или к главному, заглавному изображению статьи.

Результат: когда робот поисковика сканирует страницу, он видит задержку в загрузке самого важного контента, а пользователь видит пустой экран, что увеличивает время до первого осмысленного контента. Поисковик может решить, что контент появляется медленно, и ухудшает его оценку, поскольку первый экран должен загружаться мгновенно.

Решение: исключите все изображения и медиафайлы, расположенные на первом экране (те, что видны без прокрутки), из отложенной загрузки. Применяйте Lazy Loading только к контенту, расположенному ниже.

9. Недостаточная глубина и полнота контента

Это ошибка стратегии контента, основанная на поверхностном анализе конкурентов.

В чём суть: Google и Яндекс оценивают, насколько полно и глубоко ваш контент раскрывает тему, сравнивая его с материалами, которые уже находятся в топ-10.

Ошибка: вы пишете статью на 500 слов, тогда как средняя длина статей в топ-10 по этому запросу составляет 3000 слов. Или вы освещаете только одну часть вопроса, в то время как конкуренты дают комплексное руководство.

Результат: поисковик считает ваш контент «неполным» или «поверхностным». Даже если ваш текст хорошо написан, алгоритмы предпочитают всеобъемлющие материалы, которые с большей вероятностью удовлетворят пользователя.

Решение: анализируйте не только ключевые слова конкурентов из топа, но и их структуру, объём и подзаголовки. Ваша статья должна быть, как минимум не менее подробной, чем их.

10. Недоработка внутренней экспертности в тексте

Это ошибка, связанная с формированием доверия к вашему сайту как к авторитетному источнику.

В чём суть: поисковики и пользователи хотят видеть не просто информационные статьи, а подтверждение того, что вы действительно разбираетесь в своей нише.

Пример ошибки: агентство недвижимости публикует статью «Как купить квартиру в новостройке», но на сайте нет сопутствующих материалов, раскрывающих смежные темы: «Как проверить застройщика перед покупкой», «Что такое ДДУ и какие риски он несёт», «Как оформить ипотеку на строящееся жильё», «Налоги при продаже квартиры» и т. д.

Результат: поисковик видит отдельный хороший текст, но не тематическую систему. У сайта нет кластерной структуры, подтверждающей экспертность в сфере недвижимости. В результате в топ-10 попадают не вы, а крупные порталы вроде ЦИАН или Домклик, у которых десятки взаимосвязанных публикаций по каждой теме.

Решение: формируйте тематические кластеры. Центральная статья, например «Покупка квартиры», должна ссылаться на поддерживающие материалы: «Выбор застройщика», «Оформление ипотеки», «Проверка документов перед сделкой», «Регистрация права собственности». Это покажет поисковикам и пользователям, что вы охватываете тему комплексно и обладаете настоящей экспертностью.