Парсинг сайтов — как получить данные с сайта

Что такое парсинг

Парсинг является принятым в информатике определением синтаксического анализа. Например, когда мы читаем, то, с точки зрения филологии, проводится синтаксический анализ — сравнение увиденных на бумаге слов с теми, что имеются в нашем словарном запасе.

Программа (скрипт), которая позволяет компьютеру «читать», извлекать и проводить анализ данных, именуется парсером. Область использования подобных программ довольно обширная, вы можете ознакомиться с вариантами применения парсеров на siteclinic.ru.

Алгоритм действия парсера следующий:

- выход в сеть;

- доступ к коду веб-портала и его скачивание;

- чтение, извлечение данных и обработка;

- представление извлечённой информации в удобном формате: txt, sql, xml, html или иных вариантах.

Чем парсят сайты для технического SEO-аудита

Рассмотрим популярные программы для парсинга.

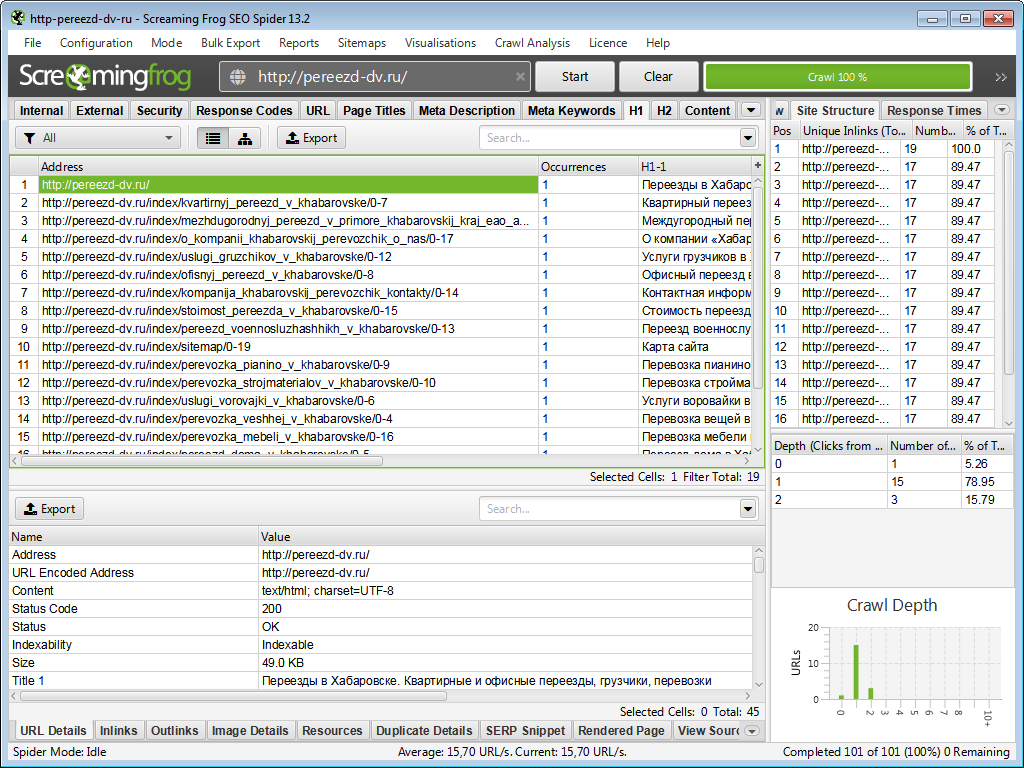

Screaming Frog SEO Spider

Screaming Frog — всем известный британский парсер — лучшая программа в своей категории. Софт очень удобный — можно быстро собрать множество характеристик сайта и также легко просмотреть эти данные и проанализировать их.

Есть платная и бесплатная версии.

У программы имеется подробный мануал, где вы можете отыскать всю необходимую информацию для работы.

Минусы — завышенная цена платной версии и не очень-то комфортный интерфейс.

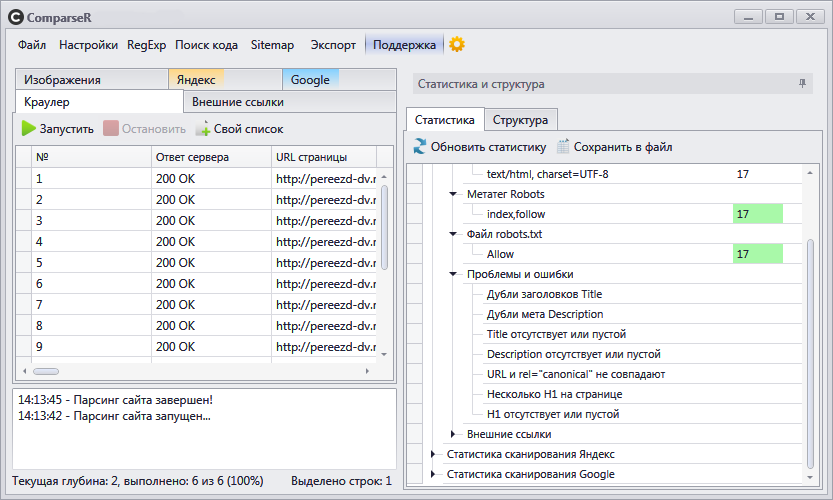

ComparseR

ComparseR — отечественный краулер, который прекрасно справляется с парсингом сайтов. Необходимо добавить, что его главная особенность — не просто спарсить странички ресурса, а ещё и проверить их индексацию в поисковых системах и сравнить с данными парсинга сайта.

Среди других фишек — сверка индексаций веб-страниц в Гугле и Яндексе и поиск определённого текста либо кода на сайте.

Есть платная и бесплатная версии.

Минус — нет перечня ссылок на страничку и со странички.

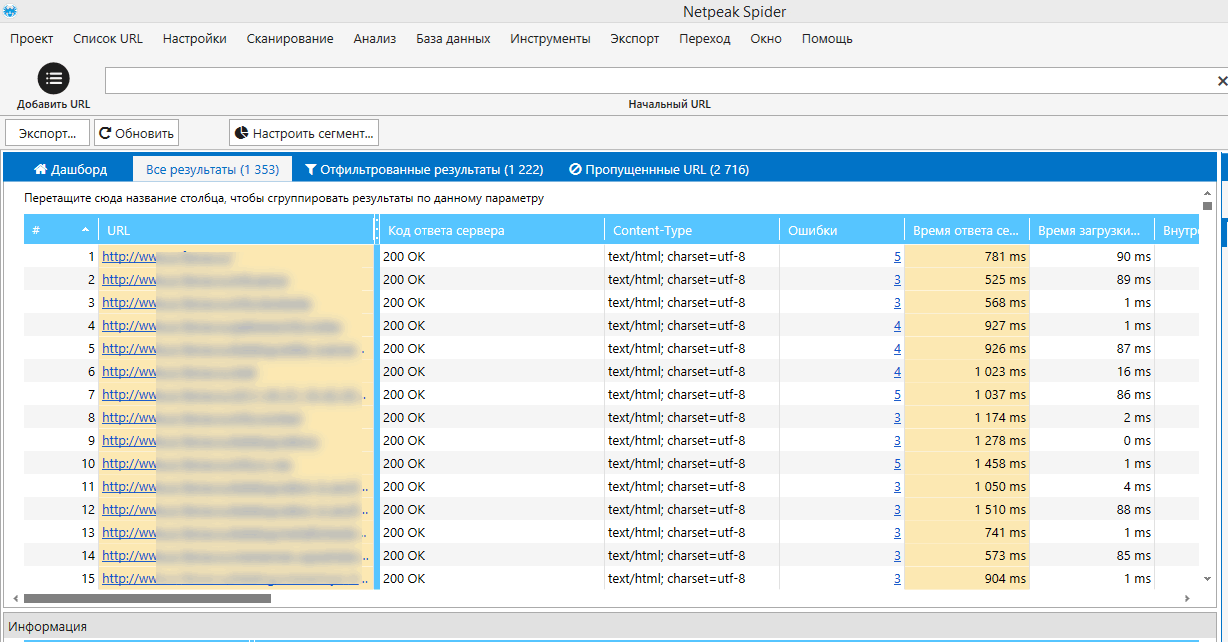

Netpeak Spider

Netpeak Spider 3.0 является новой версией парсера, премьера которой состоялась не так давно. Нетпик Спайдер — незаменимый инструмент для парсинга сайта. Главное отличие от «лягушки» — очень комфортный интерфейс на русском языке и широкие дополнительные функции.

Создатели программы говорят, что она также незаменима для работы с огромными сайтами, и при этом, ПК затрачивает мало ресурсов для работы с программой. Подобная функция на самом деле очень полезна, так как не каждая «машина» справляется с сайтами-миллионниками.

Подписка платная. Можно воспользоваться бесплатным пробным доступом, чтобы познакомиться с функционалом краулера.

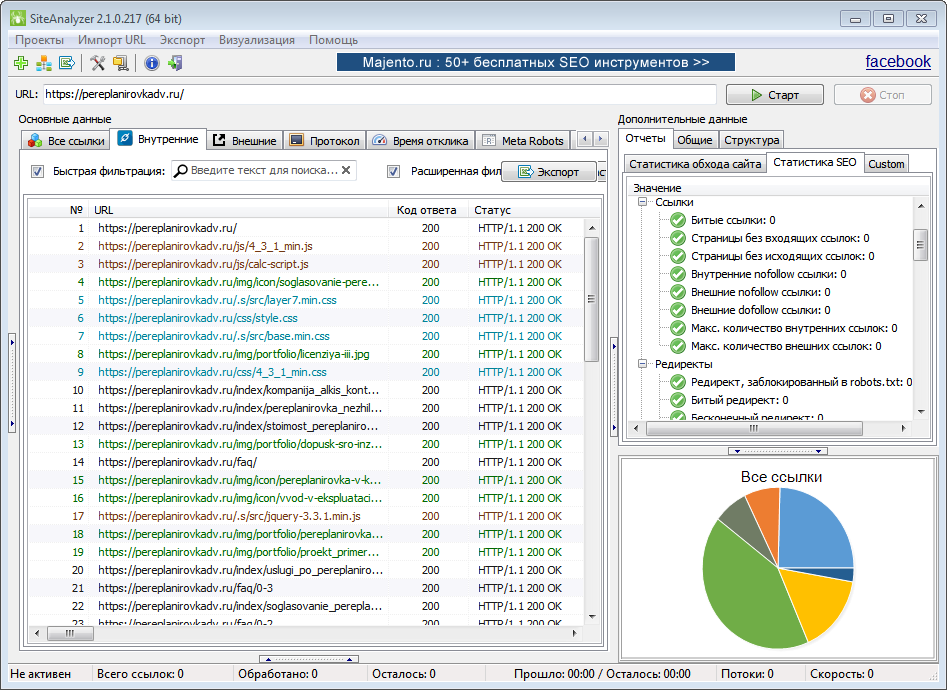

SiteAnalyzer

SiteAnalyzer — веб-краулер, позволяющий парсить сайты и проверять их основные технические и SEO-параметры.

Программа анализирует контент, ищет технические ошибки (битые ссылки, дубликаты и пр.), а также ошибки в SEO-оптимизации (title, description, h1-h3 и др.). Всего анализируется более 60 параметров.

Программа полностью бесплатна. Работает без установки на ПК.

Для чего ещё используется парсинг сайтов

Главной проблемой современного Интернета считается избыток данных, которые человек не может сам систематизировать. Поэтому у парсеров безграничные возможности — от сбора цен с сайтов конкурентов, до наполнения карточек в интернет-магазинах и поиска контактов для прямых продаж.

Примеры применения парсинга:

- Анализ ценовой политики. К примеру, чтобы подсчитать среднюю цену каких-то услуг на рынке, нужно собрать массив данных по конкурентам. Вручную эту объёмную работу практически невозможно выполнить, а парсер может её выполнить легко и быстро.

- Отслеживание изменений. Парсер может постоянно мониторить сайты конкурентов и агрегаторов для поиска новых товаров или услуг, акций и скидок по рынку. Или следить за изменениями цен у партнёров.

- Наполнение интернет-магазинов. Если вы создали онлайн-магазин, счёт товаров в нём идёт на сотни и тысячи. Своими руками делать карточку каждого товара невозможно — уйдут месяцы, поэтому применяют парсинги. В основном парсят с иностранных порталов, переводят полученные тексты машиной и получают почти готовые описания товаров. В некоторых случаях парсят текст с русскоязычных магазинов и через синонимайзер делают описание уникальным.

- Наведение порядка на сайте. Парсер помогает это сделать — найти несуществующие странички, дубликаты товаров или изображений, отсутствие некоторых свойств товара, либо несоответствие товарных остатков на складе и информации на сайте.

- Получение базы потенциальных клиентов. Есть парсинг, который связан с подготовкой, к примеру, списка лиц, принимающих решение (ЛПР) в каком-то регионе или городе. Для этого используется аккаунт на порталах для поиска работы, с открытым доступом к архивным и актуальным резюме. Этичность последующего применения такой базы любая организация определяет самостоятельно.

Занимаюсь SEO‑продвижением: от разработки стратегии до вывода сайта в топ-10 Яндекса и Google. Опыт работы — с 2009 года.